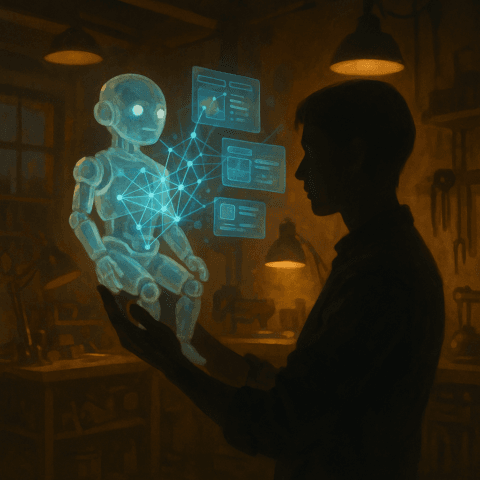

Los modelos de lenguaje de gran tamaño “LLM” o Large lenguage model, son redes neuronales que han sido entrenadas con una gran cantidad de datos para aprender y reproducir la estructura del lenguaje. Estos modelos se clasifican dentro de una rama de la Inteligencia Artificial (IA) conocida como Procesamiento del Lenguaje Natural (NLP). Los LLM pueden utilizarse para diversas tareas como traducción automática, generación automática de textos y clasificación de texto.

Modelos que siguen instrucciones: la evolución de la Inteligencia Artificial conversacional

Dentro del emocionante desarrollo de los Modelos de Lenguaje de Transformadores (LLM), se pueden identificar dos categorías principales: los modelos “base” y los modelos “Instruction Tuned LLM”. Esta distinción es fundamental para comprender cómo estos modelos han avanzado y han permitido la creación de sistemas de conversación tan impresionantes como ChatGPT.

Modelos Base: La Base del Conocimiento General

Los modelos “base” son la columna vertebral de la inteligencia artificial conversacional. Estos modelos se entrenan en la tarea fundamental de predecir la siguiente palabra en una secuencia de texto. A través de este entrenamiento, desarrollan un conocimiento general del lenguaje y la capacidad de generar texto coherente y relevante. Son como médicos clínicos con un conocimiento general de la medicina.

Cuando se interactúa con un modelo “base”, se obtienen respuestas generales que pueden ser adecuadas para una variedad de preguntas y tareas. Sin embargo, su conocimiento es amplio pero no especializado, lo que significa que pueden no ser la mejor opción para preguntas altamente específicas o tareas especializadas.

Modelos de Instrucciones: Especialización y Control

Los modelos “Instruction Tuned LLM”, por otro lado, representan una evolución significativa. Estos modelos son entrenados específicamente para seguir instrucciones basadas en ejemplos proporcionados. Pueden ser vistos como médicos especialistas que se han especializado en un área particular de la medicina, como la cardiología.

Estos modelos afinados para seguir instrucciones permiten una interacción más precisa y controlada. Pueden generar listas de resultados, componer música, responder preguntas con mayor precisión y, lo que es igualmente importante, prevenir respuestas incorrectas o inapropiadas, que a menudo se encuentran en los modelos base sin filtros. Por ejemplo, un modelo base podría contener información sobre cómo fabricar una sustancia química peligrosa, pero un modelo de instrucciones podría evitar proporcionar esta información en sus respuestas, siguiendo principios de ser “útil, honesto e inofensivo”.

¿Cuáles son las ventajas de los modelos de lenguaje de gran tamaño?

- Manejo de gran cantidad de datos: Los LLM pueden manejar una gran cantidad de datos, esencial para aprender la estructura del lenguaje.

- Aprendizaje no supervisado: A diferencia del aprendizaje supervisado donde los modelos aprenden de datos etiquetados, los LLM pueden aprender de datos no etiquetados, lo cual es una gran ventaja para tareas como la traducción automática y la generación de texto.

- Multifuncionalidad: Los LLM no tienen un solo uso específico, sino que rinden bien en usos muy diferentes, como el procesamiento del lenguaje natural, traducción automática y generación de textos.

¿Cómo funcionan los grandes modelos de lenguaje?

Los LLM funcionan aprendiendo la estructura del lenguaje a partir de una gran cantidad de datos textuales. Estos modelos, como BERT y GPT, utilizan arquitecturas de redes neuronales profundas, en particular, modelos basados en transformadores, para aprender representaciones de palabras y frases que capturan su significado y relación contextual con otras palabras.

La Revolución de los Chatbots Alineados con Instrucciones

A pesar de estos desafíos, los investigadores han estado trabajando en mejorar la utilidad de los LLM al hacer que sigan mejor las instrucciones humanas. Esto ha dado lugar a dos enfoques principales. El primero implica el uso de pares de instrucciones y respuestas escritos por humanos para ajustar el modelo base, mientras que el segundo utiliza el aprendizaje por refuerzo a partir de la retroalimentación humana (RLHF). Esta última técnica, conocida como RLHF, implica que el LLM genere múltiples respuestas posibles, que luego son calificadas por humanos para ajustar el modelo.

La combinación de estos enfoques ha llevado al desarrollo de LLM alineados con instrucciones, que son mucho mejores para seguir las instrucciones humanas y, por lo tanto, más fáciles de usar. OpenAI lanzó ChatGPT en diciembre de 2022, un chatbot basado en GPT-3.5 creado mediante esta técnica. Tras su lanzamiento, hubo un auge de chatbots basados en LLM, como Claude de Anthropic, Bard de Google y LLaMA de Meta, además de varios modelos de código abierto. Estos avances han llevado a aplicaciones emocionantes y un crecimiento exponencial de usuarios.

Los Desafíos de la Sed de Datos y los Costos de Cómputo

A pesar de sus capacidades impresionantes, los modelos de LLM se enfrentan a dos desafíos importantes. En primer lugar, existe un límite en la cantidad total de texto útil disponible para el entrenamiento, y los modelos están cerca de alcanzarlo. A medida que procesan más datos, los rendimientos de los modelos disminuyen, lo que se conoce como la “crisis de tokens”. Además, el aumento en el tamaño de los modelos conlleva costos computacionales significativos. La próxima generación de modelos requerirá cientos de millones de dólares en recursos de cómputo, lo que plantea preocupaciones sobre la sostenibilidad.

¿Existen inconvenientes en los modelos de lenguaje de gran tamaño?

- Costo: El entrenamiento de los LLM puede ser costoso debido a la gran cantidad de datos y la necesidad de hardware especializado.

- Tiempo de entrenamiento: Los LLM pueden ser lentos de entrenar debido a la complejidad de los modelos.

- Interpretabilidad: Los LLM pueden ser difíciles de interpretar debido a la naturaleza opaca de los modelos.

Los LLM, siendo una parte integral de la IA y el NLP, han demostrado tener un impacto significativo en varias aplicaciones. Aunque presentan desafíos, su capacidad para manejar grandes volúmenes de datos y aprender de manera no supervisada les confiere una ventaja distintiva. Además, los avances en otras áreas de la IA, como el aprendizaje profundo y las redes neuronales, continúan impulsando el desarrollo y la eficacia de los LLM.