En un mundo cada vez más dominado por las interacciones digitales, la efectividad de las interfaces de usuario (UI) y las infografías es crucial para una comunicación y una experiencia de usuario óptimas. ScreenAI, el nuevo modelo de lenguaje visual de Google Research, se posiciona como una solución de vanguardia para comprender y interactuar con estos elementos visuales. Desarrollado por Srinivas Sunkara y Gilles Baechler, este modelo no solo maneja las tareas tradicionales asociadas a las interfaces de usuario y las infografías, sino que también introduce innovaciones significativas en la comprensión del diseño y la interacción con el contenido visual.

Para qué sirve ScreenAI

- Comprensión visual avanzada: ScreenAI puede analizar y comprender interfaces de usuario de aplicaciones y sitios web, así como diversos tipos de infografías. Esto incluye la capacidad de identificar y clasificar elementos como botones, campos de texto, imágenes y otros componentes de la interfaz.

- Interacción intuitiva con UI: El modelo está diseñado para interactuar con interfaces de usuario de la misma manera que lo haría una persona, lo que implica comprender instrucciones en lenguaje natural y ejecutar acciones correspondientes, como “haz clic en el botón de búsqueda” o “abre el menú de configuración”.

- Generación automática de datos de entrenamiento: Utilizando aprendizaje automático, ScreenAI puede generar conjuntos de datos de anotación de pantalla para el entrenamiento de otros modelos de IA, facilitando la creación de sistemas automatizados para la comprensión de UI.

- Control de calidad y soporte de decisiones: A través de tareas de respuesta a preguntas (QA), ScreenAI puede extraer y proporcionar información específica de las UI y las infografías, lo que puede ser utilizado para pruebas de control de calidad y soporte de decisiones basado en datos visuales.

- Accesibilidad mejorada: ScreenAI tiene el potencial de mejorar la accesibilidad para usuarios con discapacidades, interpretando visualmente el contenido de las pantallas y ofreciendo respuestas o acciones basadas en texto.

- Navegación automatizada: El modelo puede guiar la navegación a través de una UI basada en comandos en lenguaje natural, lo que podría ser utilizado en la automatización de pruebas de software o para asistir a los usuarios en la navegación de aplicaciones complejas.

- Resumen de contenidos: ScreenAI puede resumir el contenido presentado en una pantalla, proporcionando una descripción concisa y precisa de la información disponible.

Arquitectura del modelo de ScreenAI

ScreenAI se destaca por su arquitectura innovadora, diseñada específicamente para procesar y entender interfaces de usuario e infografías complejas mediante la combinación de técnicas avanzadas de visión por computadora y procesamiento del lenguaje natural.

1. Arquitectura PaLI

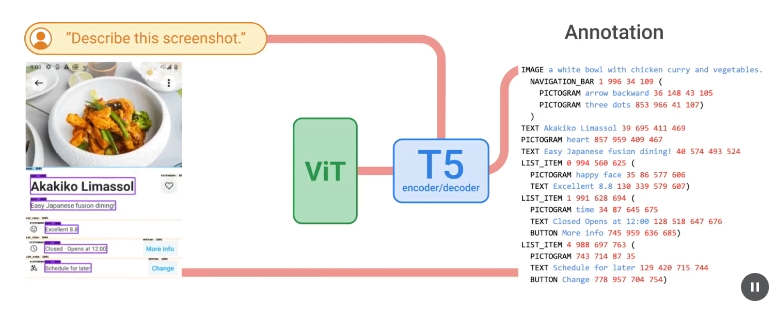

La arquitectura principal de ScreenAI se basa en el modelo PaLI, que es un sistema de codificación-decodificación multimodal. Esta arquitectura consta de dos partes principales:

- Codificador multimodal: Utiliza un transformador de visión (Vision Transformer, ViT) para procesar imágenes. Este transformador convierte los elementos visuales en incrustaciones, es decir, representaciones numéricas que capturan la esencia de los objetos en las imágenes. Además, el codificador multimodal procesa también incrustaciones de texto, tomando la concatenación de la imagen y las incrustaciones de texto como entrada. Esto permite al modelo comprender y procesar conjuntamente información visual y textual.

- Decodificador autorregresivo: Este componente toma las incrustaciones generadas por el codificador y las transforma en texto. Es capaz de generar descripciones, respuestas a preguntas y comandos basados en la entrada visual y textual que ha sido procesada por el codificador.

2. Estrategia de Parcheo Flexible (pix2struct)

Además de la arquitectura básica de PaLI, ScreenAI implementa una estrategia de parcheo flexible, introducida por pix2struct. En lugar de utilizar un patrón de cuadrícula fija para procesar imágenes, ScreenAI ajusta las dimensiones de la cuadrícula basándose en la relación de aspecto nativa de la imagen de entrada. Esto es esencial para manejar con precisión imágenes de diversas formas y tamaños, asegurando que el modelo comprenda correctamente el contenido sin distorsionar elementos importantes del diseño.

3. Proceso de entrenamiento en dos etapas

ScreenAI se entrena mediante un proceso en dos etapas que optimiza su capacidad para entender y generar datos relevantes:

- Preentrenamiento Autosupervisado: En esta fase inicial, el modelo utiliza aprendizaje autosupervisado para generar etiquetas de datos a partir de capturas de pantalla. Estas etiquetas son utilizadas posteriormente para entrenar el componente ViT y el modelo de lenguaje, permitiendo a ScreenAI desarrollar una comprensión preliminar de las interfaces de usuario y las infografías.

- Ajuste Fino: Después del preentrenamiento, el modelo pasa por una fase de ajuste fino donde se utilizan datos etiquetados manualmente por evaluadores humanos. Durante esta etapa, el modelo ViT se mantiene fijo (congelado), y el entrenamiento se concentra en mejorar la capacidad del decodificador para generar respuestas y descripciones precisas basadas en los datos más específicos y detallados proporcionados por los humanos.

4. Generación de datos y anotación

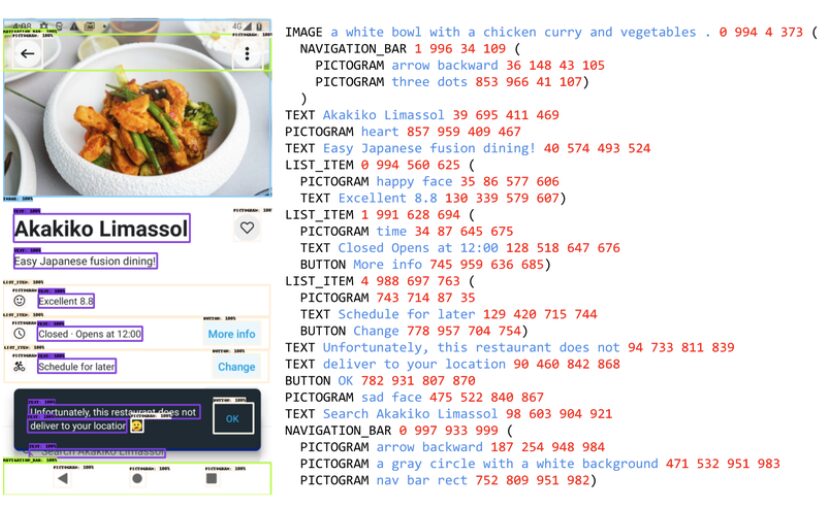

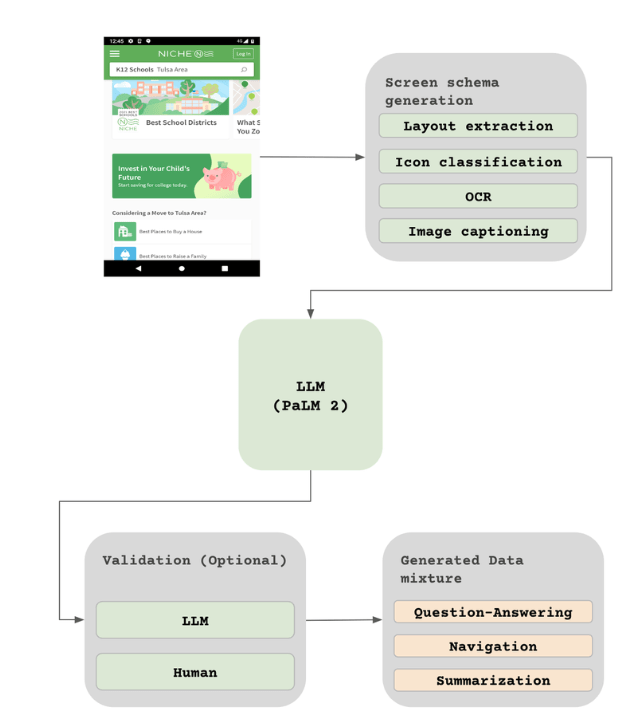

Para preparar los datos necesarios para el entrenamiento, ScreenAI emplea un método detallado que incluye:

- Compilación de Capturas de Pantalla: Se recopilan extensas colecciones de capturas de pantalla de diversos dispositivos utilizando técnicas de exploración programática.

- Anotación Automatizada: Se utilizan modelos avanzados como DETR para identificar y etiquetar elementos de la interfaz de usuario dentro de las capturas de pantalla. Estos elementos son clasificados detalladamente, incluso utilizando clasificadores de iconos cuando es necesario.

- Generación de Subtítulos y Texto: Para elementos que no pueden ser cubiertos completamente por clasificadores, el modelo utiliza técnicas de subtítulos de imágenes para generar descripciones que proporcionan contexto adicional.

Capacidades de comprensión y generación de datos

Una de las contribuciones más destacadas de ScreenAI es su capacidad para generar automáticamente conjuntos de datos de entrenamiento. Mediante la anotación de pantalla, el modelo identifica y cataloga elementos de la UI, proporcionando una base para tareas de resumen, respuesta a preguntas y navegación por la interfaz.

Los nuevos conjuntos de datos

Google Research también ha lanzado tres nuevos conjuntos de datos: Screen Annotation, ScreenQA Short y Complex ScreenQA. Estos no solo permiten evaluar las capacidades del modelo en tareas controladas, sino que también ofrecen un marco para futuras investigaciones y mejoras en el campo del procesamiento de lenguaje y visión combinados.

El desarrollo de ScreenAI no solo establece nuevos estándares en el campo de la IA, sino que también abre la puerta a mejoras significativas en cómo interactuamos con los medios digitales. Sin embargo, aún existen desafíos, especialmente en la mejora del rendimiento del modelo en comparación con enfoques de última generación.

ScreenAI de Google Research representa un avance significativo en la tecnología de comprensión visual y lingüística. Con su capacidad para manejar tareas complejas de UI e infografías y sus innovadores métodos de generación de datos, ScreenAI está bien posicionado para liderar la próxima ola de innovaciones en la interacción hombre-máquina.