Meta ha anunciado el lanzamiento de SAM 2 (Segment Anything Model 2), una herramienta de inteligencia artificial avanzada diseñada para identificar y segmentar objetos en imágenes y videos. Esta nueva versión de SAM promete revolucionar la edición de videos y la creación de contenido mediante una segmentación precisa y en tiempo real. En este artículo, exploraremos las características innovadoras de SAM 2, sus aplicaciones y el impacto potencial en diversas industrias.

Evolución de SAM a SAM 2

El Segment Anything Model original de Meta, lanzado el año pasado, estableció un nuevo estándar en la segmentación de imágenes. Sin embargo, SAM 2 va un paso más allá al integrar capacidades avanzadas para la segmentación de videos, lo que permite un seguimiento preciso de objetos en movimiento y su identificación en tiempo real. SAM 2 ha sido desarrollado para ser un modelo unificado que puede manejar tanto imágenes como videos, proporcionando una experiencia de segmentación sin interrupciones.

Características Principales de SAM 2

- Segmentación en tiempo real: SAM 2 es capaz de segmentar objetos en videos en tiempo real, ofreciendo una precisión sin precedentes y reduciendo significativamente el tiempo de interacción necesario.

- Código abierto: Meta ha lanzado SAM 2 como código abierto bajo la licencia Apache 2.0, permitiendo a los desarrolladores y empresas construir aplicaciones personalizadas.

- Dataset SA-V: SAM 2 se ha entrenado utilizando el nuevo dataset SA-V, que incluye aproximadamente 51,000 videos del mundo real y más de 600,000 «masklets» o máscaras espaciales-temporales.

- Generalización sin adaptación: SAM 2 puede segmentar cualquier objeto en cualquier video o imagen, incluso en dominios visuales que no ha visto previamente, eliminando la necesidad de adaptaciones personalizadas.

Aplicaciones de SAM 2

Las aplicaciones potenciales de SAM 2 son vastas y variadas, abarcando desde la creación de efectos de video hasta la mejora de herramientas de anotación para sistemas de visión por computadora. A continuación, se destacan algunas de las aplicaciones más prometedoras:

- Edición de video: Los creadores de contenido pueden usar SAM 2 para aplicar efectos de video y realizar ediciones precisas de manera más eficiente.

- Ciencia y medicina: SAM 2 puede ser utilizado para el seguimiento de animales en peligro de extinción en grabaciones de drones o para localizar regiones específicas en videos médicos, como durante procedimientos laparoscópicos.

- Automatización y robótica: La capacidad de SAM 2 para segmentar objetos en tiempo real puede ser aprovechada en vehículos autónomos y en la robótica para mejorar la percepción y la interacción con el entorno.

- Anotación de datos: Las plataformas de anotación de datos pueden integrar SAM 2 para acelerar significativamente el proceso de anotación, reduciendo millones de horas de trabajo humano.

Cómo Funciona SAM 2

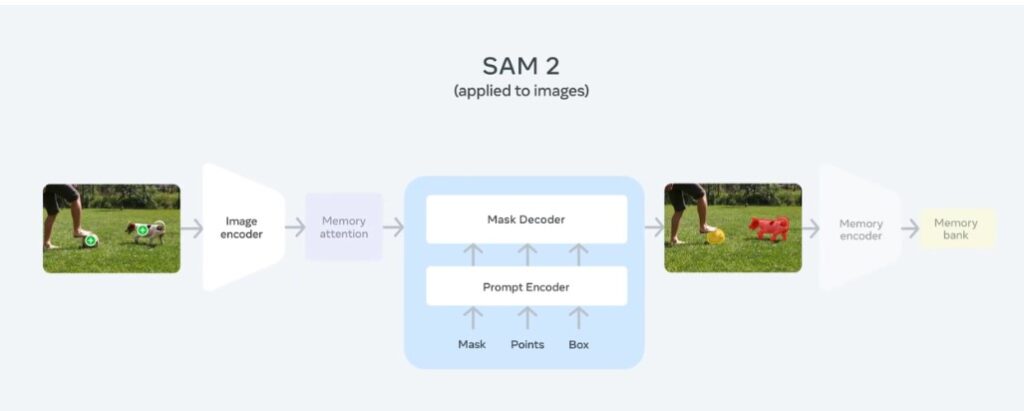

SAM 2 utiliza una arquitectura avanzada que incluye un mecanismo de memoria para recordar información previamente procesada y mejorar la precisión de segmentación en videos. Este enfoque permite que SAM 2 genere predicciones de máscaras a lo largo de todos los fotogramas de un video y refine estas predicciones mediante interacciones adicionales.

Tarea de Segmentación Visual Promotable

SAM 2 está diseñado para tomar entradas de puntos, cuadros o máscaras en cualquier fotograma de un video y predecir una máscara de segmentación para el objeto objetivo. Este modelo puede iterar y refinar estas predicciones en cualquier fotograma, lo que permite obtener resultados precisos y personalizados.

Arquitectura Unificada para Imágenes y Videos

La arquitectura de SAM 2 generaliza la segmentación de imágenes al dominio del video. Con un decodificador de máscaras y componentes de memoria, SAM 2 puede almacenar y utilizar información sobre objetos segmentados para mejorar las predicciones en fotogramas subsiguientes.

Memoria Temporal

SAM 2 emplea un mecanismo de memoria temporal que guarda información sobre los objetos segmentados en fotogramas anteriores. Esto le permite mejorar la precisión y consistencia de las máscaras a lo largo de toda la secuencia de video. La memoria temporal es crucial para manejar los desafíos de segmentar objetos en movimiento y en entornos cambiantes.

Dataset SA-V: Construyendo el Mayor Dataset de Segmentación de Video

El dataset SA-V es fundamental para el rendimiento de SAM 2. Este conjunto de datos incluye anotaciones detalladas de objetos y partes de objetos en diversos escenarios del mundo real. La recolección de estos datos se ha realizado de manera interactiva, utilizando SAM 2 para mejorar continuamente la precisión y la velocidad de anotación.

Resultados

SAM 2 supera significativamente a los modelos anteriores en la segmentación de video interactiva, mostrando mejoras en precisión y velocidad. Este modelo también demuestra un rendimiento robusto en benchmarks de segmentación de video existentes y es capaz de operar en tiempo real, lo que lo hace ideal para aplicaciones prácticas.

Limitaciones y Futuras Mejoras

Aunque SAM 2 presenta un rendimiento impresionante, existen áreas donde aún puede mejorar. La segmentación de objetos en videos largos o en escenarios complejos con cambios drásticos de vista de cámara sigue siendo un desafío. Meta continúa trabajando en mejorar estas capacidades y en automatizar aún más el proceso de anotación de datos.

SAM 2 representa un avance significativo en la segmentación de objetos en imágenes y videos, ofreciendo herramientas poderosas para una variedad de aplicaciones. Con su enfoque de código abierto y su capacidad de generalización, SAM 2 está preparado para impulsar nuevas innovaciones y aplicaciones en el campo de la inteligencia artificial.