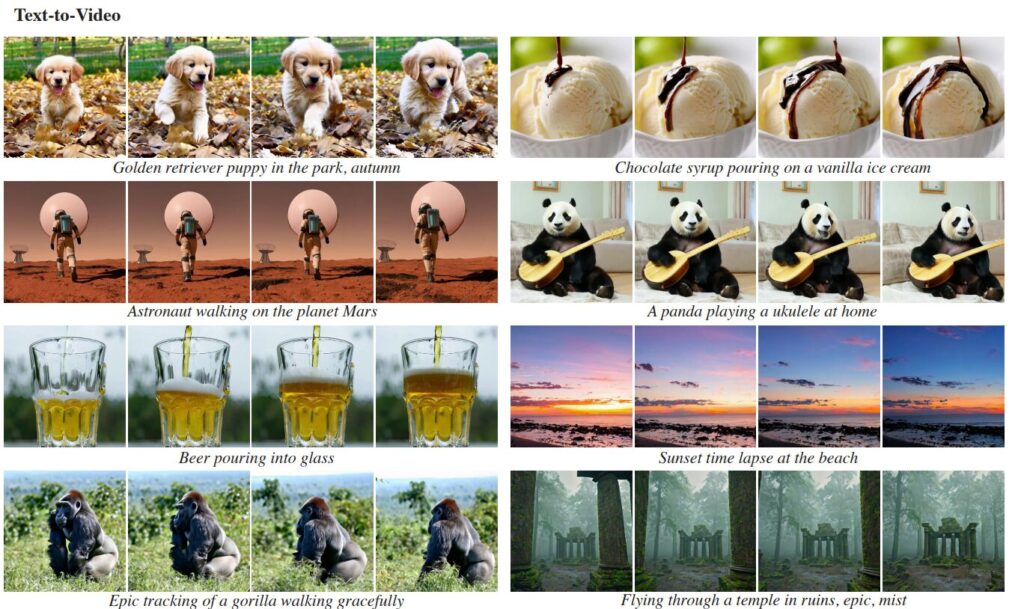

La inteligencia artificial ha experimentado avances significativos en los últimos años, especialmente en la generación de imágenes realistas a partir de textos descriptivos. Desde los primeros modelos generativos capaces de producir imágenes estáticas hasta la creación de animaciones y vídeos, el campo ha experimentado un avance significativo. Modelos de texto a imagen (T2I), como DALL-E o Midjourney, han demostrado la capacidad de crear imágenes fotorrealistas de alta resolución a partir de descripciones de texto complejas, abriendo un nuevo universo de posibilidades creativas y técnicas. Sin embargo, la generación de vídeo text-to-video (T2V) ha presentado desafíos adicionales, especialmente debido a la complejidad añadida del movimiento y los requisitos de memoria y computación que esto implica.

Google, con su modelo Lumiere, ha dado un paso adelante en la síntesis de video a través de IA. Lumiere no es solo un modelo de generación de video; es una ventana al futuro del contenido digital. Utilizando una arquitectura avanzada, este modelo es capaz de generar vídeos que no solo son visualmente impresionantes, sino que también capturan la esencia del movimiento real y diverso, un desafío crucial en la síntesis de vídeo.

Funcionamiento de Lumiere

La innovación detrás de Lumiere reside en su arquitectura Space-Time U-Net (STUNet). A diferencia de los modelos anteriores, Lumiere puede generar la duración temporal completa de un video de una sola vez, procesándolo en múltiples escalas espacio-temporales. Esto representa un avance significativo sobre los métodos anteriores, que luchaban por mantener la coherencia temporal a lo largo de los videos.

Lumiere emplea Modelos Probabilísticos de Difusión, que inician con un patrón aleatorio de ruido y lo transforman progresivamente en datos coherentes, aproximando una distribución de datos reales a través de múltiples pasos de desruido. Este proceso permite al modelo aprender a generar contenido que no solo parece real, sino que también se alinea con condiciones específicas, como descripciones textuales o información espacial. El sistema se compone de dos partes principales: un modelo base que crea un clip de video en una resolución baja y luego un modelo de superresolución espacial (SSR) que mejora la calidad de estos clips hasta alcanzar una alta resolución, asegurando que la mejora de detalles sea temporalmente coherente para garantizar la fluidez del video final.

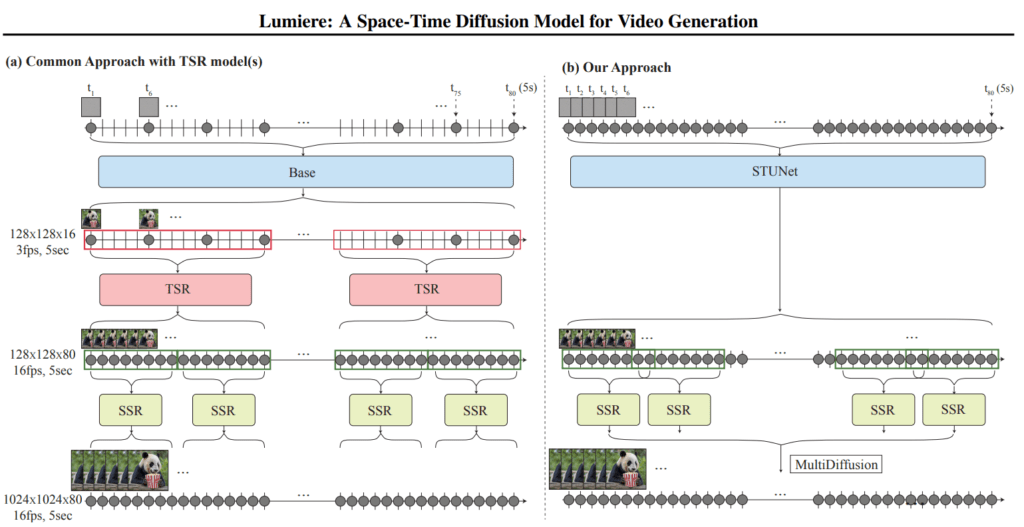

En la imagen anterior Google muestra las ventajas de su modelo Lumiere, sobre las técnicas anteriores, principalmente en la coherencia temporal y la eficiencia en la generación de vídeo completo.

- Enfoque Común con Modelos TSR (Temporal Super Resolution):

- En el panel (a), se muestra el enfoque tradicional de generación de vídeo, donde primero se generan marcos clave distantes en el tiempo (por ejemplo, t1, t6) utilizando un modelo base.

- Luego, estos marcos clave son procesados por modelos de superresolución temporal (TSR), que generan los marcos intermedios para crear una secuencia de vídeo.

- Finalmente, se aplica un modelo de superresolución espacial (SSR) para mejorar la resolución espacial de los marcos del vídeo, llegando hasta una resolución de 1024×1024 a 80 cuadros por segundo (fps), manteniendo una duración de vídeo de 5 segundos.

- El enfoque de Lumiere con STUNet (Space-Time U-Net):

- En el panel (b), se muestra el enfoque de Lumiere. A diferencia del enfoque común, STUNet genera toda la secuencia de video de una vez en un solo paso, en lugar de generar primero marcos clave y luego interpolar entre ellos.

- STUNet se representa como un bloque continuo que procesa el tiempo de manera uniforme a lo largo del vídeo.

- Al igual que el método tradicional, también se utiliza la superresolución espacial (SSR) para mejorar la resolución espacial del vídeo generado.

- Este enfoque se describe como “MultiDiffusion”, sugiriendo que se utiliza un enfoque de difusión múltiple o iterativa para generar un vídeo completo y de alta resolución.

Lumiere ha sido entrenado en un conjunto de datos que contiene 30 millones de vídeos, con textos descriptivos para cada uno. La evaluación del modelo se realizó en una colección de 113 indicaciones de texto, demostrando una alta calidad y coherencia en el movimiento de la cámara. Además, en comparación con otros modelos T2V difusión prominentes, Lumiere ha sido preferido por los usuarios, mostrando una mejor alineación con las indicaciones de texto.

Arquitectura de Lumiere

Lumiere maneja datos a lo largo del tiempo y el espacio para generar vídeos a partir de texto o imágenes, utilizando una combinación de técnicas de procesamiento de señales y aprendizaje profundo. El modelo está diseñado para mantener la coherencia a lo largo del tiempo, lo que es crucial para la creación de vídeos que parezcan naturales y fluidos.

- Space-Time U-Net (STUNet): Este panel muestra la arquitectura principal del modelo, un tipo de red neuronal que es capaz de procesar datos tanto espaciales (como imágenes) como temporales (como el tiempo en un vídeo). La arquitectura realiza una disminución y luego un aumento de la resolución, tanto espacial como temporal, para generar un vídeo. Esto se representa en la imagen como bloques que se reducen en tamaño y luego se expanden, con la imagen de un oso como ejemplo de entrada y salida del modelo.

- Convolution-based Inflation Block: Este bloque describe un componente del modelo que utiliza convoluciones, que son operaciones matemáticas clave en el procesamiento de imágenes. Se utiliza para inflar la representación de los datos para que el modelo pueda trabajar con información más detallada en cada paso. Este proceso incluye capas de convolución 2D y 1D, normalización y activación, seguidas de una proyección lineal.

- Attention-based Inflation Block: Similar al bloque anterior, pero en lugar de usar convoluciones, usa mecanismos de atención. La atención ayuda al modelo a enfocarse en partes específicas de los datos al generar o procesar el vídeo. También incluye una proyección lineal al final del proceso.

Aplicaciones y capacidades de Lumiere

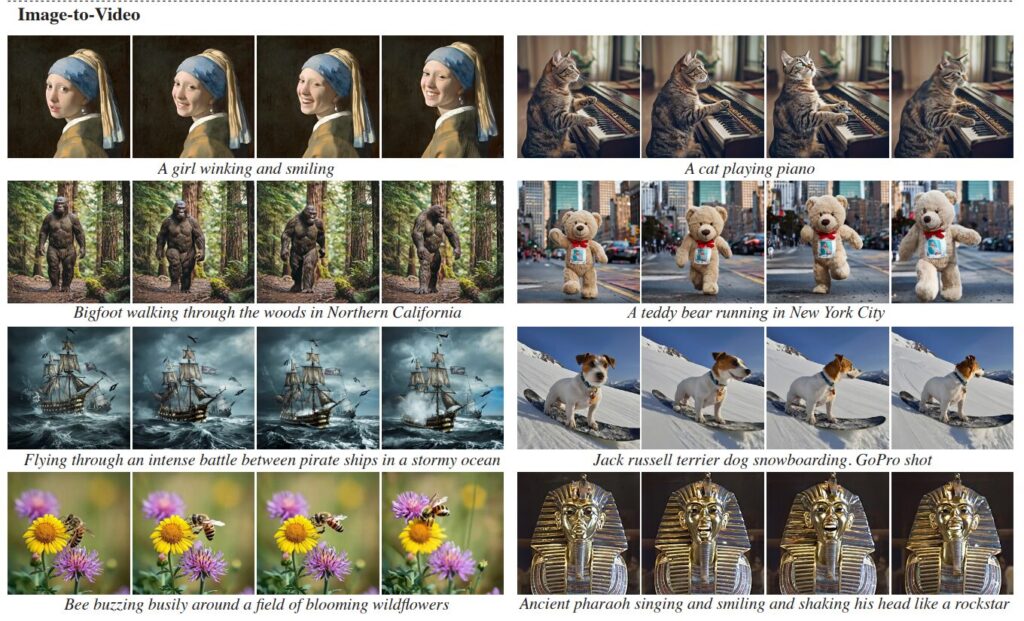

Las capacidades de Lumiere se extienden más allá de la mera generación de video. Incluyen la generación de video estilizado, la edición de video y la conversión de imagen a video. Esta versatilidad abre un mundo de posibilidades para creadores de contenido, cineastas y artistas, proporcionando una herramienta poderosa para llevar su creatividad a nuevas alturas.

- Generar Vídeo a Partir de Imágenes: Tomando el primer fotograma de un vídeo como entrada, Lumiere puede generar vídeos que comienzan con ese marco y muestran un movimiento coherente a lo largo de toda la duración del vídeo.

- Inpainting de Vídeo: Lumiere puede completar regiones enmascaradas de un vídeo proporcionado por el usuario, permitiendo la sustitución o inserción de objetos y ediciones localizadas.

- Cinemagraphs: Esta aplicación permite animar el contenido de una imagen solo dentro de una región específica proporcionada por el usuario, manteniendo el resto estático.

A pesar de sus impresionantes capacidades, Lumiere y tecnologías similares enfrentan desafíos significativos. La calidad visual, la duración del video y la representación precisa del movimiento natural son áreas que aún necesitan mejoras. Estos desafíos representan oportunidades emocionantes para futuras investigaciones y desarrollos.

Mirando hacia el futuro, la generación de video mediante IA tiene el potencial de transformar múltiples industrias. Desde la creación de contenido interactivo hasta aplicaciones educativas y de entrenamiento, las posibilidades son casi ilimitadas. Con el tiempo, podríamos ver cómo estas tecnologías se vuelven más accesibles y abren nuevos caminos para la narrativa digital y la creación de contenido.

Lumiere de Google no es solo un avance tecnológico; es un catalizador para la innovación en el campo de la generación de contenido digital. A medida que estas tecnologías continúen evolucionando, podrían remodelar fundamentalmente la forma en que creamos, interactuamos y experimentamos el contenido visual en el mundo digital.