Tabla de contenidos

En el ámbito de la inteligencia artificial generativa, OpenAI ha dado un paso monumental con el lanzamiento de Sora, un modelo de IA que transforma instrucciones escritas en videos realistas. Este avance representa un salto cualitativo en la forma en que interactuamos con la tecnología, y abre nuevas posibilidades en la producción de contenido digital.

Sora, el nuevo modelo de generación de video de OpenAI

OpenAI, conocida por sus contribuciones significativas en el campo de la IA, como GPT y DALL-E, ahora presenta Sora. Este modelo se basa en una comprensión profunda del lenguaje y la capacidad de generar escenas complejas que incluyen múltiples personajes, movimientos específicos, y detalles de fondo precisos. Lo que distingue a Sora es su capacidad para crear videos que no solo son visualmente impresionantes sino también ricos en narrativa y emociones.

Cómo funciona Sora

La tecnología detrás de Sora se basa en algoritmos avanzados de aprendizaje automático (Machine Learning), aprendizaje profundo (Deep Learning) y procesamiento de lenguaje natural (NLP), permitiéndole comprender y generar respuestas en un contexto amplio y con una precisión asombrosa. El modelo acepta instrucciones en texto simple y las convierte en videos realistas.

Convertir datos visuales en parches: Un nuevo enfoque para la generación de video

El modelo de Sora se basa en la conversión de datos visuales en parches. Al igual que los grandes modelos de lenguaje (LLM) han revolucionado la comprensión y generación de texto al entrenar con datos a escala de Internet, Sora busca replicar este éxito en el dominio visual. Los LLM utilizan tokens para manejar una diversidad de textos, desde código hasta matemáticas y varios idiomas. Sora, en cambio, utiliza “parches visuales” como su piedra angular, una estrategia inspirada en la eficacia demostrada de los parches para representar datos visuales en trabajos anteriores.

Parches latentes del Espacio-Tiempo

Sora utiliza idea de convertir videos en una secuencia de “parches latentes del espacio-tiempo”. Este proceso comienza con la compresión del video original en una representación más manejable, reduciendo su complejidad espacial y temporal. Luego, esta representación comprimida se descompone en parches, pequeñas piezas de información que capturan aspectos específicos del contenido visual en el tiempo y el espacio.

Estos parches funcionan de manera similar a los tokens en el procesamiento del lenguaje natural, actuando como las unidades básicas con las que el modelo trabaja. Esta analogía es importante porque, al igual que los tokens pueden representar palabras o conceptos en un texto, los parches latentes encapsulan información visual crítica que Sora utiliza para aprender y generar nuevos contenidos visuales. Este enfoque permite a Sora manejar eficientemente videos e imágenes de diferentes resoluciones, duraciones y relaciones de aspecto, ofreciendo una capacidad de generación visual enormemente flexible y poderosa.

Transformadores de escalado y generación de Video

El corazón del proceso generativo de Sora reside en los “transformadores de difusión”, una tecnología que toma parches visuales ruidosos y los transforma en versiones “limpias” o finales. Pero, ¿cómo funciona esto exactamente? La difusión es un proceso iterativo donde se empieza con un estado inicial ruidoso y, paso a paso, se va refinando esta información hasta alcanzar una salida coherente y de alta calidad. La escalabilidad y eficacia de los transformadores de difusión significan que Sora no solo puede generar contenido visual de alta calidad sino que también puede hacerlo de manera eficiente a gran escala.

Comprensión del Lenguaje

La comprensión del lenguaje por parte de Sora va más allá de la simple traducción de texto a imágenes o video. Gracias a la integración de tecnologías avanzadas de procesamiento de lenguaje natural, como GPT, Sora puede interpretar instrucciones textuales complejas y generar subtítulos descriptivos que enriquecen el contenido visual. Este entendimiento profundo del lenguaje permite a Sora capturar la esencia de las indicaciones del usuario, asegurando que los videos generados no solo sean visualmente impresionantes sino también contextualmente relevantes y ricos en contenido.

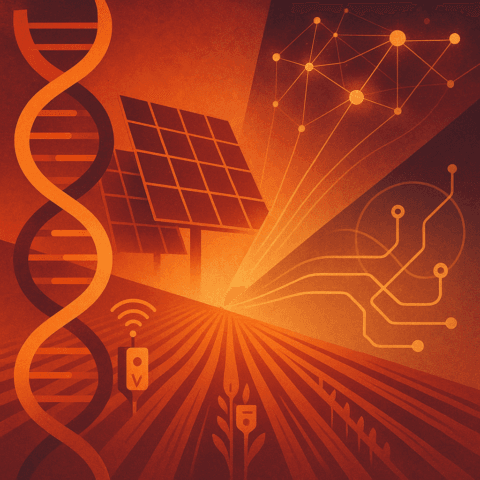

Capacidad de simulación y generación de Imágenes

Más allá de su capacidad para generar y editar videos, Sora también puede crear imágenes estáticas de alta resolución, organizar parches en una cuadrícula espacial para generar instantáneas detalladas y simular aspectos del mundo físico con una fidelidad sorprendente.

Además el modelo tiene la capacidad de crear escenarios que muestran una consistencia 3D y una interacción compleja entre elementos, lo que refleja un entendimiento profundo y realista del mundo físico. Esto significa que Sora puede generar contenido que no solo parece real sino que también se comporta de manera coherente con las leyes físicas y lógicas del mundo, desde la manera en que la luz interactúa con diferentes superficies hasta la simulación de movimientos y acciones de personas y objetos dentro de un entorno virtual.

Proceso de generación de video

- Compresión de video: se utiliza una red neuronal para comprimir el video en un espacio latente de dimensiones inferiores.

- Extracción de parches: se extrae una secuencia de parches de espacio-tiempo a partir de la representación latente comprimida.

- Generación de video: un modelo transformador de difusión aprende a generar parches “limpios” a partir de parches con ruido.

- Decodificación: un modelo decodificador convierte la representación latente generada en un video de píxeles.

Ventajas de Sora

- Escalabilidad: puede generar videos e imágenes de diferentes resoluciones, duraciones (con una duración máxima de 1 minuto) y relaciones de aspecto

- Flexibilidad: puede generar videos a partir de indicaciones de texto, imágenes o videos de entrada

- Capacidades emergentes: puede simular algunos aspectos del mundo físico, como la consistencia 3D, la permanencia de objetos y la interacción con el entorno

Funcionalidades de Sora

- Edición de video: permite editar videos a partir de indicaciones de texto.

- Interpolación de video: puede crear transiciones perfectas entre videos con diferentes temas.

- Generación de imágenes: puede generar imágenes de alta resolución.

- Simulación de mundos: puede simular mundos físicos y digitales.

- Animación de imágenes: permite crear un video a partir de una imagen

Sora abre un abanico de posibilidades que apenas comenzamos a explorar. La continua expansión de las capacidades de estos modelos promete revolucionar no solo cómo generamos y consumimos contenido digital, sino también cómo comprendemos y interactuamos con el mundo a nuestro alrededor.

Este avance hacia simuladores de propósito general del mundo físico y digital representa un emocionante futuro para la inteligencia artificial, con implicaciones profundas en casi todos los aspectos de nuestra vida y trabajo. La promesa de Sora y modelos similares es enorme, ofreciendo la creación de mundos digitales complejos y realistas al alcance de nuestras manos, impulsando la innovación en una multitud de campos y transformando nuestra relación con la tecnología.